29 июля 2019

Искусственный интеллект и истинные эмоции: стоит ли доверять машинам?

Константин Иванов

По материалам The Verge

По мере того, как искусственный интеллект все больше используется для принятия решений в нашей жизни, перед разработчиками встает проблема, как повысить его «подкованность» в эмоциональной сфере. Это означает автоматизацию решения ряда эмоциональных задач, которые для человека возникают естественным образом – например, посмотреть на лицо человека и понять, что он чувствует.

Чтобы этого добиться, технологические компании, такие как Microsoft, IBM и Amazon, предлагают то, что они называют «алгоритмами распознавания эмоций», определение того, что чувствуют люди, на основе анализа лица. Например, если кто-то нахмурил брови и надул губы, это означает, что он рассердился. Или если глаза расширились, брови подняты, а рот растянут, это означает страх. И так далее.

Клиенты компаний могут применять эти технологии самыми различными способами, начиная от систем наблюдения, которые будут выискивать угрозу, распознавая «сердитые» лица, до программ для найма работников, которые будут отсеивать скучающих и немотивированных соискателей.

Многие технологические компании продают алгоритмы, которые обещают достоверно определять эмоции, основываясь всего лишь на выражении лица конкретного человека. Источник: Microsoft

Впрочем, уверенность в том, что мы можем запросто сделать выводы о состоянии человека, основываясь на визуальных данных, сталкивается с противоречиями, и, согласно докладу о новом исследовании в данной области, научного обоснования для нее нет.

«Компании могут говорить что угодно, но данные очевидны, — говорит Лиза Фельдман Барретт, профессор психологии в Северо-Восточном университете, одна из пяти авторов исследования. – Можно распознать, что человек хмурится, но это не то же самое, что распознать гнев».

Заказчиком исследования выступило Американское психологическое общество, и пятерых ученых попросили подвергнуть тщательному анализу то, что вроде бы очевидно. Каждый ученый представлял какой-то «лагерь» в области исследования эмоций. «Мы не были уверены, что придем к согласию, но получилось именно так», — говорит Барретт. Для изучения данных потребовалось два года, а доклад охватывал результаты более тысячи различных исследований.

Результаты исследований очень подробны, полностью их можно найти здесь, но общая мысль такова: для выражения эмоций имеется очень широкий спектр способов, что делает сложным определение того, что чувствует человек, на основании простого набора мимических движений.

«В среднем, испытывая гнев, люди хмурятся менее 30% времени, — говорит Барретт. — Так что нахмуренные брови – не проявление гнева, а лишь одно из многих проявлений. То есть более 70% времени рассерженные люди не хмурятся, более того, они часто хмурятся, не будучи сердитыми».

А это, в свою очередь, означает, что компании, которые используют ИИ для оценки человеческих эмоций, вводят покупателей в заблуждение. «Неужели вам хотелось бы, чтобы результаты оценивались таким образом? — спрашивает Барретт. — Вы готовы к тому, что в суде, при найме на работу, в аэропорту алгоритм работал верно лишь в 30% случаев?».

Исследование не отрицает, что могут существовать обычные, «типичные» выражения лица. Как не отрицает и того, что наша вера в коммуникативную роль выражения лица имеет большое значение в обществе (не забываем, что видя человека лично, мы получаем гораздо больше информации о его эмоциях, чем нам дает примитивный анализ лица).

В докладе определяется, что в сфере изучения эмоций существует большое разнообразие принятых на веру постулатов. Один из них, в частности, опровергают исследователи, это идея достоверного «отпечатывания» эмоции через выражение лица. Данная теория уходит корнями в работу психолога Пола Экмана 1960-х гг., которую ученый позже развил.

Исследования, которые показывают устойчивую корреляцию между определенными выражениями лица и эмоциями, зачастую основаны на неверной методологии, как говорится в докладе. Например, они задействуют актеров, которые используют преувеличенные выражения лица в качестве отправной точки для отображения эмоций. И когда подопытных просят обозначить эти выражения, им часто предоставляют ограниченный выбор эмоций, что приводит их к определенному согласию.

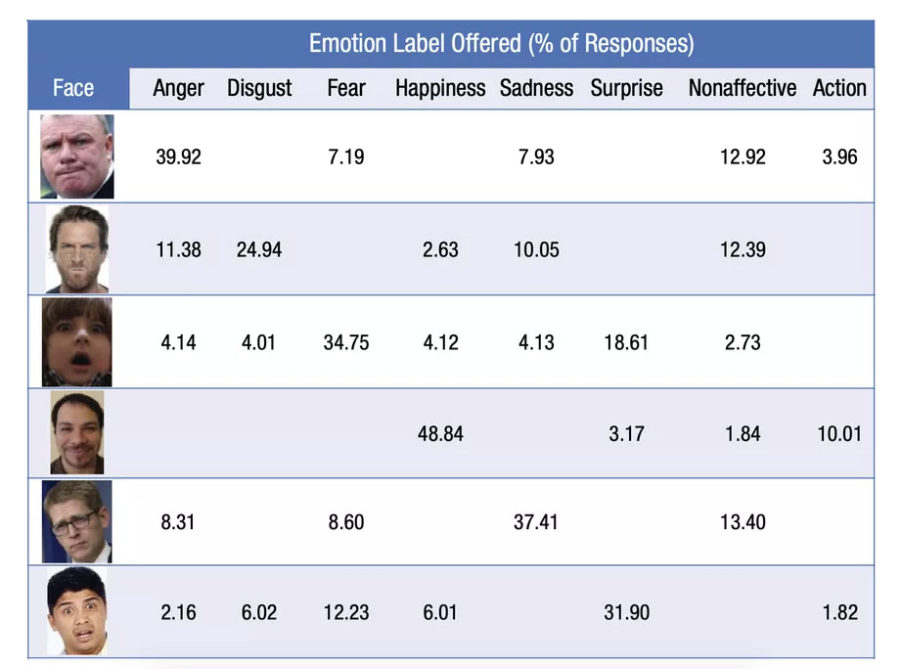

Когда людей просят охарактеризовать эмоции на лицах и при этом не дают выбора из конкретных вариантов, их ответы, как показывает графика, значительно варьируются

«Люди интуитивно понимают, что эмоции – гораздо более сложная вещь, – замечает Барретт. – Когда я говорю людям: “Иногда вы кричите в гневе, иногда плачете от злости, иногда смеетесь, а иногда молча сидите и планируете уничтожение ваших врагов”, – это для них убедительно. Я говорю: “Слушайте, когда в последний раз кто-нибудь выигрывал “Оскар” за то, что хмурился от злости?”. Никто не посчитал это крутой актерской игрой».

Однако подобные нюансы редко принимаются во внимание компаниями, которые продают инструменты распознавания эмоций. В маркетологическом описании алгоритмов Microsoft компания говорит, что преимущества ИИ позволяют их программе «распознать восемь ключевых эмоциональных состояний… основываясь на универсальных выражениях лица, которые отражают эти состояния», то есть провозглашается как раз то, что опровергает доклад.

Барретт и ее коллеги не первый год предупреждают, что наша модель распознавания эмоций слишком примитивна. В противовес этому компании, которые продают эти инструменты, часто говорят, что их анализ основан на большем количестве сигналов, нежели просто выражение лица. Сложность в том, как сбалансированы эти сигналы, если это вообще правда.

Одна из компаний-лидеров на $20-миллиардном рынке распознавания эмоций, Affectiva, говорит, что экспериментирует со сбором дополнительных метрик. Например, в прошлом году она запустила инструмент, который должен измерять эмоции водителей на основе анализа лица и речи. Другие ученые занимаются созданием таких метрик, как анализ походки и отслеживание глаз.

В своем заявлении CEO компании Affectiva и ее сооснователь Рана эль Калиуби сказала, что доклад Барретт и ее коллег «очень в русле» работы компании. «Как и авторам этого доклада, нам не по душе наивность индустрии, которая застряла на шести базовых эмоциях и прямом соотношении выражений лица и эмоциональных состояний,– говорит эль Калиуби. – Соотношение выражения и эмоции – явление очень тонкое, сложное и не прототипическое».

Барретт уверена, что в будущем мы сможем более точно измерять эмоции посредством более сложных метрик. Но это не остановит распространения нынешних ограниченных методов.

В машинном обучении мы особенно часто видим метрики, которые используются для принятия решений – и не потому, что они достоверны, а просто потому, что они могут быть применены для измерения. Это технология, которая превосходно умеет находить взаимосвязи, что может привести к самым разным видам ложного анализа: от поиска постов в соцсетях, которые размещает няня ребенка, для определения ее «настроения» до анализа корпоративных стенограмм с целью предсказания курсов акций. Часто даже само определение искусственного интеллекта окутывает явление незаслуженным ореолом достоверности.

Если распознавание эмоций станет обычным делом, существует опасность, что мы просто примем это и начнем подстраиваться под недостатки метода. Сейчас люди могут предсказать, как разные алгоритмы воспримут их действия в сети (и, например, не лайкать посты с детьми, чтобы не получать потом рекламу подгузников). А в будущем мы можем начать изображать утрированные выражения лица, зная, как их интерпретируют машины. И они не будут особенно отличаться от того, что мы станем демонстрировать другим людям.

Барретт говорит, что, возможно, самый важный вывод из доклада заключается в том, что нам надо начать думать об эмоциях как о более сложном явлении. Выражение эмоций разнообразно, сложно и ситуативно. Она сравнивает необходимость перемен с исследованиями природы видов Чарльза Дарвина, с тем, как его работа перевернула упрощенные представления о царстве животных.

«Дарвин понял, что биологическая категория вида не имеет единой сущности, это категория, объединяющая крайне разнообразные индивиды. Это совершенно точно справедливо и для эмоциональной сферы».

Пока ученые подвергают сомнению надежность существующих алгоритмов, они повсеместно внедряются в реальной жизни, в том числе и в нашей стране. Как вы думаете, правомерно ли использование настолько несовершенной технологии, например, в банках или при приеме на работу? Пока что выходит, что постоянный надзор Большого Брата – это только полбеды, а настоящая проблема – в интерпретации собранных о нас с вами сведений.

Вся статья — это концентрированный КО ?