26 апреля 2020

Камера 600 МП у вас в смартфоне?

Владимир Нимин

В прошлом году камеры смартфонов снова заболели гигантоманией. Вроде, был определенный момент, когда все заговорили, что главное – не количество мегапикселей, а алгоритмы, занимающиеся обработкой фото. В пример приводился и Google Pixel 3, который с одним объективом фотографировал так, что все завидовали. Ещё за образец рациональности можно взять Samsung, выпускавшую что Galaxy S8, что Galaxy S10 с основным фотомодулем на 12 МП.

Всем был такой подход хорош. Но были и печали. Во-первых, больше всего загрустили тупые компании, которые не могли придумать, как же им написать хорошие алгоритмы для обработки фотографий, чтобы на выходе конфета была. Во-вторых, грустили маркетологи. Ну как это можно говорить, что камера стала ещё лучше, если физически она такая же? А ещё грустили производители объективов, потому что физически уже выжали всё, что только можно было, и тоже столкнулись с вопросом, как продавать одно и то же, но дороже каждый год.

И вот задумались производители камер, а как ещё улучшить картинку. А тут больших хитростей нет и принцип базовый – чем больше размер сенсора камеры, чем больше света он способен захватить, тем больше деталей будет и вообще тем лучше будет качество фотосъёмки. А каждая матрица состоит из миллионов пикселей, и чем больше разрешение у матрицы, тем больше в ней пикселей. Соответственно, каждый пиксель меньшего размера, что, в свою очередь, означает, что он немного менее аккуратно захватывает свет, чем пиксель большего размера. И тогда инженеры палец к носу прикинули и нашли решение в два шага.

Первый шаг заключается в увеличении матрицы. Например, у новых Samsung Galaxy S20 Ultra со 108 МП камерой размер пикселей всего 0.8 микрона. Такого же размера пиксели в камерах 64 МП и 48 МП. Но матрица у Samsung размером 1/1.3 дюйма. А у Huawei P30 Pro с 40 МП камерой матрица была «всего» 1/1.7.

Шаг второй – решение парадокса. Парадокс следующий: чем больше матрица, тем больше света. И это хорошо. Однако чем выше разрешение, тем меньше пиксели размером и тем менее четко они захватывают свет. Соответственно, для хорошего фото нужна и матрица большая, и пиксели тоже! Хотя бы 1.4 микрона, как у того же Pixel 3 или у iPhone 11. А лучше ещё больше! И тогда придумали производители заниматься пиксель-биннингом, или, говоря проще, объединять маленькие пиксели в один. Отличная идея – и инновационно, и полезно, и вообще модная тема! Потому что краудсорсинг популярен и полезен везде – и при сборе денег, и при вычислениях!

Все мы знаем про 48 МП камеры, что там пиксель-биннинг 4-в-1 и на выходе получаются фотографии размером 12 МП. И чем больше пикселей объединяются, тем лучше. У Samsung хоть камера и 108 МП, но фото на выходе всё равно 12 МП, таким образом, получается объединение 9-в-1. Как говорит сама компания, пиксели объединяются в массивы 3х3, то есть 0.8μm*3, и получается большой пиксель размером 2.4μm. Гораздо больше среднестатистического!

И вот все снова счастливы. Тут и маркетинг с большими цифрами, и улучшение качества, и полный прогресс! Но возникает вопрос, а куда дальше могут шагнуть производители камер для смартфонов? Правильный ответ – продолжить увеличивать матрицу и количество пикселей в ней, которые потом будут объединяться. Например, Samsung в конце 2019 года похвасталась, что её новые пиксели будут размером всего 0.7μm. Но тут надо будет искать баланс между размером сенсора, чтобы он по-прежнему в телефон помещался, и размером пикселей, дабы они могли адекватное количество света собирать.

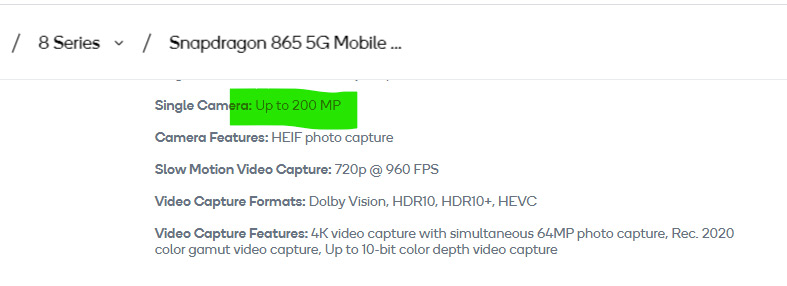

Кстати, на сайте Qualcomm в спецификациях флагманского чипсета Snapdragon 865 написано, что умеет он поддерживать камеры разрешением до 200 МП.

И сразу же утечки появляются, что уже к концу года нас ждут первые камеры с модулем 192 МП. Почему 192? Потому что там для 12 МП фотографии (4032 на 3024 точек), которая считается определенным стандартом размера, нужно 16 пикселей объединить в один.

Однако, согласно утечкам, такая камера засветилась в смартфоне с чипсетом Snapdragon 765, который, как и флагман, поддерживает камеры до 200 МП. Оно и понятно. Такой чипсет нацелен на средний ценовой сегмент. А так как сейчас, помимо железа, важны ещё и алгоритмы, то проще сначала протестировать все нюансы работы на более дешевых аппаратах, заставив алгоритм не так хорошо обрабатывать фотографии, как потом на флагманах.

А недавно Samsung рассказали в официальном пресс-релизе, что сейчас команда занимается разработкой фотомодуля, который будет превосходить человеческий глаз. Я не знал, но оказывается, что наш глаз соответствует разрешению примерно в 500 МП. А если повезло и природа была к вам благосклонна, то, возможно, у вас целых два глаза. И тогда в мозгу происходит ваш собственный биологический пиксель-биннинг, ToF сенсоринг и много чего ещё. А если пьёте или таблетки какие принимаете, то у вас там ещё AR, VR или MR! Работают они, вероятно, не так чётко, как в смартфоне, но однозначно интереснее!

Заключение

К слову, Samsung себе позволила немного пофантазировать, рассказав, где могут использоваться модули, видящие больше человеческого глаза. Так, современные камеры могут делать снимки, которые видны человеческому глазу на длинах волн от 450 до 750 нанометров. Новые камеры будут способны видеть, например, ещё ультрафиолет. А это, в свою очередь, можно будет использовать для диагностики рака кожи. Так как, оказывается, здоровые клетки отличаются по цвету от больных. А потом глава команды, отвечающей за сенсоры, Йонгин Парк сказал, что они занимаются разработкой не только модулей, отвечающих за захват изображения. Они ещё и делают сенсоры, умеющие фиксировать запахи и вкусы. И добавил: «Датчики, которые выходят за пределы человеческих чувств, скоро станут неотъемлемой частью нашей повседневной жизни, и мы воодушевлены тем, что такие датчики должны делать невидимое видимым и помогать людям, выходя за пределы того, на что способны наши собственные чувства».

И такие слова очень классные, так как потом все эти улучшающие датчики вставят в людей, и люди станут лучше с носом, как у собаки, а глазом, как у орла!

Читая первую часть статьи, появилась мысль: как-то это напоминает сарказм. А потом — нет, показалось.

Просто автор, видимо, «пьет или таблетки какие принимает».

Так о чем статья?

Как можно не уловить сарказм в данной статье я не пойму.

Да и статья про то, что все вернулось на круги своя. Раньше были маленькие матрицы и много мегапикселей. Сейчас же матрицы выросли, а мегапиксели нет. Так что самсунг и ему подобные опять делают маленькие матрицы и много мегапикселей. А людям норм, они с лопаты причавкивая едят.

Мой комментарий так же с сарказмом.

В последнее время прочитываю обзоры на старые модели смартфонов и ужасаюсь: как мы раньше ходили с 5 и 8 МП камерами? А когда просматриваю свои старые фотографии, сделанные на «древние» смартфоны, и не только — снять неплохое фото на какой-нибудь SE 990i (был такой) или А-серию от Самсунга 2015, или, Боже упаси, на Nokia C3-01 (все эти аппараты были) — легко. Как и на N8.

Шумы, ужасные пиксели при кроме, чёрное пятно ночью — да мне и такого качества хватает.

Поддался 2 года назад маркетинговым уловкам яблочников и корейцев. Сейчас понимаю: платить оверК рублей за «качество» я не готов. Куплю, пожалуй, снова Nokia N8

Кабы софт поголовно не протух, то имело бы смысл. У меня брат даже до сих пор как-то пользуется. На данный момент я бы таким аналогом н8 назвал оригинальный SE.

Спору нет. Был такой аппарат 2 года, очень радовал. Как и сама ось яблочников. Но (внимание: вселенский сговор), в очередной версии камеру реально испортили.

Про софт: согласен целиком и полностью. Однако, Н8 и сегодня без десятков, а то и сотен, мегабайт кода для обработки способен в обычных условиях делать неплохие фото.

Погорячился, сказав, что куплю Н8: все же без мессенджеров в наших реалиях практически невозможно.

А купить оригинальный SE — хорошая идея

Кабы софт поголовно не протух, то имело бы смысл. У меня брат даже до сих пор как-то пользуется. На данный момент я бы таким аналогом н8 назвал оригинальный SE.

«В прошлом году камеры смартфонов снова заболели гигантоманией.»

Только не в прошлом году, а ещё раньше, после того, как с 12-ти и 16-ти мегапиксельных камер, стандартных на то время для флагманов, сначала перешли на 24 Мп, затем 32 Мп, позже на 48 Мп, потом на 64 Мп, и, наконец, на 108 Мп.

И да, сейчас Samsung работает над 500 Мп матрицей, а не 600 Мп, как указано в заголовке.

«оказывается, что наш глаз соответствует разрешению примерно в 500 МП»

По самому оптимистичному расчёту эта оценка завышена раз в десять. По пессимистичному значительно больше. По точному — раз в пятьдесят или сто ;).

Данные: типовая нормальная острота человеческого зрения считается равной одной угловой секунде.

Поле зрения человека весьма неравномерно по высоте и ширине, но нас не интересует периферическое зрение, в котором разрешающая способность вообще никакая (в сто раз ниже). Возьмём центральную зону бинокулярного зрения. Это примерно 110 градусов (что характерно, «более-менее высококачественное» цветовое зрение имеет ещё меньший угол). Внутри этого поля разрешающая способность тоже меняется, причём очень сильно.

Разрешающая способность в одну секунду — это примерно 0.075мм на расстоянии 250мм. Хотя практически применяют 0.1мм для оценки максимума и даже 0.2 для практического примения (по различимости реальных объектов). Ну или из данных выше, если 1м (различимый на расстоянии 3438м) принять равным этому самому различимому 1 «пикселу», по формуле треугольника, в случае если угол «у глаза» составляет 110 градусов — «дальная сторона» будет равна примерно 9800 «пикселей». Если номинировать по центру. Такова максимально теоретически возможная разрешающая способность глаза по горизонтали от условии всех допущений, что острота одинакова про всему углу (что не так, к краю она сильно падает), что мы берём такой большой угол (в то время как высококачественное зрение даёт угол практически вдвое меньше) и т.д.

Если продолжить допущения и принять вертикаль такой же (что опять же не так, но пусть), то получаем 10к*10к — 100м размер матрицы со всеми допусками. Без них это каких-то, 20, ну пусть даже 50м, в зависимости от методов подсчета и точности учёта всяких факторов. Причем первая цифирь ближе к истине и упоминалась ранее в разных источниках. Откуда взяли 500 — тайна сия великая есть.

P.S.: нашел график разрешающей способности сетчатки. Все ОЧЕНЬ печально. Например, максимальная разрешающая способность — в центральней ямке, при удалении на 5 градусов падает втрое, на 20 градусов в сторону уже в десять раз. На 55 в сторону это уже разница в тридцать раз. По хорошему надо брать интеграл вообще ;).

Берём среднее (чтобы не брать интеграл). На диапазоне углов 0-10 это где-то 0.5, на 10-20 уже 0.2, на 20-30 всего 0.1, на 30-40 где-то 0.05, на 40-50 и 50-60 уже трудно вычислить, но не более 0.03. Итого среднее всего лишь 0.15 (!). То есть 9800*0.15= … полторы тысячи точек! Даже если я неточно посчитал график — все равно цифры невелики. Глаз, правда, компенсирует это постоянным движением, «сканируя» то, что рассматривает, поэтому суммарное «получаемое» изображение все же имеет больше пары мегапикселов 😉 (как я уже написал, раз в десять — реально), но в любом случае цифра 500 нарисована маркетологами.

«нифига не понятно, но ооочень интересно»)))))

а если серьезно, то возможно имелось ввиду разрешение которое перекроет то разрешение которое получит человеческий мозг при длительном разглядывании объекта/направления с одной точки, но писать такую громоздкую конструкцию маркетологи тупо не могут ибо останутся непонятыми…. А вот получить такое разрешение картинки в памяти мозга при длительном разглядывании таки вполне возможно если просматривать хотябы 180 градусов по горизонтали и 120 градусов по вертикали самой чувствительной зоной глаза в идеальных условиях и из миллионов изображений собирать одну целую (чем собственно наш мозг постоянно и занимается, не забывая при этом еще и переворачивать картинку))))….

«нифига не понятно, но ооочень интересно»)))))

а если серьезно, то возможно имелось ввиду разрешение которое перекроет то разрешение которое получит человеческий мозг при длительном разглядывании объекта/направления с одной точки, но писать такую громоздкую конструкцию маркетологи тупо не могут ибо останутся непонятыми…. А вот получить такое разрешение картинки в памяти мозга при длительном разглядывании таки вполне возможно если просматривать хотябы 180 градусов по горизонтали и 120 градусов по вертикали самой чувствительной зоной глаза в идеальных условиях и из миллионов изображений собирать одну целую (чем собственно наш мозг постоянно и занимается, не забывая при этом еще и переворачивать картинку))))….

«нифига не понятно, но ооочень интересно»)))))

а если серьезно, то возможно имелось ввиду разрешение которое перекроет то разрешение которое получит человеческий мозг при длительном разглядывании объекта/направления с одной точки, но писать такую громоздкую конструкцию маркетологи тупо не могут ибо останутся непонятыми…. А вот получить такое разрешение картинки в памяти мозга при длительном разглядывании таки вполне возможно если просматривать хотябы 180 градусов по горизонтали и 120 градусов по вертикали самой чувствительной зоной глаза в идеальных условиях и из миллионов изображений собирать одну целую (чем собственно наш мозг постоянно и занимается, не забывая при этом еще и переворачивать картинку))))….

«нифига не понятно, но ооочень интересно»)))))

а если серьезно, то возможно имелось ввиду разрешение которое перекроет то разрешение которое получит человеческий мозг при длительном разглядывании объекта/направления с одной точки, но писать такую громоздкую конструкцию маркетологи тупо не могут ибо останутся непонятыми…. А вот получить такое разрешение картинки в памяти мозга при длительном разглядывании таки вполне возможно если просматривать хотябы 180 градусов по горизонтали и 120 градусов по вертикали самой чувствительной зоной глаза в идеальных условиях и из миллионов изображений собирать одну целую (чем собственно наш мозг постоянно и занимается, не забывая при этом еще и переворачивать картинку))))….

Согласен, но тогда чего уж останавливаться полном поле зрения и на 500? Давайте ещё человека голову вращать заставим и круговую панораму посчитаем. Или сферическую! Там ещё больше будет ;). Но, все же, вынужден поправить — без поворота головы в стороны собрать такое разрешение не получится. Только в зоне по центру, градусов на 50-60, может даже 90. Но не больше, при неподвижной голове глаза все таки ограничены в изменении выбираемой точки центрального зрения, на краях поля зрения (задолго до 180/120) все равно будут периферические зоны сетчатки задействованы.

если абстрагироваться от технической составляющей, то думаю конечным результатом всей этой движухи инженеры видят создание «идеальной» полусферы/сферы (идеальной в кавычках потому что собственно изображение которое моделирует наш мозг на основе данных получаемых глазами тоже далеко от идеала и ограничено уже собственно параметрами самого мозга, который просто не в состоянии воспринять больше) изображения, которое человеческое существо не сможет отличить от реальности даже при длительном разглядывании с одной точки без использования специального оборудования… А по достижении этого параметра дальнейшее движение в сторону расширения регистрируемых диапазонов (от инфракрасного до ультрафиолетового излучения) чтобы потом можно было искусственно визуализировать и эти диапазоны (ну например двигая ползунок под фото менять визуализированные диапазоны), а может и увеличение детализации «идеальной полусферы» до состояния когда можно будет разбивать ее на отдельные части (цифровое увеличение) и части все одно будут неотличимы от реальности для комплекса человеческого глаза/мозга… ХЗ их знает…

пы.сы. я несомненно абсолютно дилетантски рассуждаю и совсем не знаю правильную терминологию, но мне кажется, что именно это и хотят сделать в конечном счете..

С точки зрения «идеальной» схемы, когда разрешение соответствует круговому обзору с максимальным качеством — сходится. Но круговой (шаровой тем более) обзор на одном сенсоре пока получать вроде не умеют :), да и технически это довольно неудобно, искажения — сшивка «дешевле».

Не так. Разрешение по всей площади снимка, должно быть равно максимальному глаза, в центральной ямке, да еще с учетом микросаккад. Ибо мы можем перевести взгляд и уточнить детали, а кадр статичен и должен эти детали содержать сразу, мало ли какая его область нас заинтересует.

Я написал про это, что взгляд сканирует картинку, поэтому суммарное разрешение несколько выше. Но даже в таком ключе — зона сканирования не равна зоне бинокулярного зрения, надо брать угол меньше, порядка «нормального объектива», градусов 50-60. Суммарно будет все равно на порядок с лишним меньше указанной дикой цифры.

Слишком много инфы было в вашем комменте)), но теперь понял. 500 мп кадра даже для квадратной матрицы дает сторону 22 мп. Даже для кругового обзора, это 62 кп на градус. Дикая цифра! Сейчас на сторону всего кадра на порядок меньше и то достаточно.

22 Кп на сторону 62 пикселя на градус — как раз пиксель на угловую минуту. то есть если из подобных строгонаучных подсчетов они и высосали эти 500Мп (а маркетогоги могут), то это +- 90-градусный ширик на 20Мп). То есть самсунг спалился, что все их нынешние мегапуксели на самом деле дутые, раз глаза все равно не дотягивают))

Ага. Ошибся немножко, на порядок)). Но маркетологи все равно неплохо насосали. Этож сферический кадр (360*60)²

Минуте. Одной минуте. И «угловая минута» это масло масленое, правильнее будет сказать «соответствует углу зрения в одну минуту». А дальше все верно, прямо по учебнику офтальмологии 😉

Вы абсолютно правы, минуте — mea culpa. «Угловая» чисто как указание к чему относится, чтобы народ не пугался что это, но формально вы совершенно правы, это тавтология.

P.S.: Дык считал по графику с учебника считай.

Возьмем супер камеру в 500МП, сделаем супер фотку, засунем в инстаграм разрешением максимум в 1080P (1 Мп).

Профит. Маркетологи выиграли.

Зато подпись будет на фото, что было сфотографировано на 600мегапихелей.

Ну если супер камера на 500 Мп будет делать супер-фотки (с динамическим диапазоном, как на самых дорогих зеркалках), то почему бы и не засунуть это супер-фотку в 1080p? Художественная ценность ведь останется.

а если кропнуть

quad bayer и прочее объединение мелких пикселей несет много полезного при обработке такой многопиксельной фотографии, хотя на выходе будут те же 12 мп. возможность изменения глубины резкости при пост обработке и другая информация получаемая при помощи мелких пикселей. если позволяют технологии, то почему нет? по сути это расширенная информация об одном пикселе, а не просто количество света попавшего на него.

Quad Bayer — это действительно очень полезная технология. Но, Quad Bayer не имеет никакого отношения к возможности изменения глубины резкости при пост-обработке. Вот расширенный динамический диапазон (HDR) — да, это прямая заслуга Quad Bayer.

Не совсем точно выразился. На основе технологии quad bayer и подобных в перспективе можно будет изменять глубину резкости в изображениях, точку фокусировки и подобное. Теоретические основы для таких алгоритмов есть

Это совершенно неверно. Объединение происходит под одним цветным фильтром. Соответственно, при дебаеризации процесс восстановления реального цвета каждой точки усложняется или даже становится невозможным.

Восстановить цвета точек еще можно более-менее точно, когда объединяется 4 пикселя в один, но уже дальше (9 пикселей на Galaxy S20 Ultra) все печально. Если объединять 16 пикселей в один, тогда восстановить реальный цвет вообще невозможно и такая камера будет выдавать нормальные снимки разве что в 12 Мп.

Это если брать в лоб. Если же яркостную инфу объединять под одним фильтром с последующим применением алгоритма получения ч/б изображения (псевдодебаеризация), а цветовую усреднять после дебариезации каждого пикселя, проблем нет. Но, как написал выше (ниже?), смысла тоже нет. Злосчастный сигнал/шум.

Хм… не совсем понимаю, как это поможет все восстановить цвет. К примеру, возьмем группу из 16 пикселей. Верно, «яркостная инфа» будет полноценной, то есть, в ч/б мы получим точную картинку. Но что значит «усреднять» цвет? Если на красном фоне будет тонкая линия (5-10 пикселей) зеленого цвета или, к примеру, как восстановить узор, скажем, на зеленом фоне разбросаны цветные точки. И разбросаны так, что в группе из 16 пикселей все крайние — зеленые, а внутри должны быть точечки другого цвета. Откуда его взять? У нас будет тупо зеленые квадраты по 16 пикселей с разной яркостью внутри.

Естественно мелкие детали будут потеряны. Как сделать правильно? Ничего нового изобретать не надо. Смотрите алгоритмы изменения разрешения обычных изображений — билинейный, бикубический, ланцош, — уж не помню какой лучший для уменьшения. RGBG матрицы недалеко ушел от RGB фотографий. Для спецов доработать их под новые условия, как два пальца.

Хм, но причем здесь алгоритмы изменения разрешения (билинейный, бикубический и пр.)? Мы же совершенно не об этом говорим. Дебайеризация — это же не процесс изменения разрешения, а, если так можно выразиться, алгоритм «сборки RGB-цвета» одного пикселя из отдельных R, G, B и G пикселей. Как мне помогут все перечисленные Вами алгоритмы, работающие с полноценными RGB-пикселями, восстановить правильный цвет, когда у нас такая неразбериха творится (по 16 пикселей накрытых одним цветом)?

Еще раз повторю свою мысль — чем больше пикселей мы будем объединять под одним цветным фильтром, тем меньше у нас будет шансов восстановить четкую картинку в полном разрешении. Если объединять по 16 пикселей и получать 12 Мп фотку, тогда о каких деталях на 192 Мп может идти речь?

Основная проблема мелких пикселей, соотношение сигнал/шум. Хоть объединяй их, хоть усредняй, операция будет производится как над полезным сигналом, так и над шумом. В отличии от физического укрупнения пикселя, значительного улучшающего этот параметр.

С глазом же сравнивать вообще нельзя. Это очень сложный программно-аппаратный комплекс у участием нейросетей)) У нас есть очень небольшая область четкого зрения, которую мы наводим на разные объекты, плюс микросаккады для дополнительной детализации этой области.

Коллега как-то проводил эксперимент. Рассчитал поле зрения объектива и зная размер шрифта, соответственно расстояние, с которого линии букв занимают ~1 пиксель. Понимая, что идеальной четкости не будет, текст должен оказаться читаемым. Фиг вам! Уж не помню с какого меньшего расстояния он смог его прочесть и сколько пикселей занимала линия, но с тех пор, возник еще один термин «информационный пиксель» — пиксель несущий достаточно информации о точке поверхности, в отличии от физического, несущего хоть какую-то инфу.

В обиходе определяю его снимая таблицу проверки зрения или тестовую страницу принтера, выбираю строку в которой буквы еще узнаваемы, но не резкие, и по 1% ресайжу фотографию, пока они не станут достаточно четкими. Если уменьшение ведет к ухудшению читаемости, ориентируюсь по предыдущей строке букв. Оставшееся в снимке количество пикселей и есть «информационные», размещать в этой оптической системе больше которого нет смысла и только ухудшает сигнал/шум.

В 1.5-2 раза будет разница в приведённом эксперименте. Можно довести до идеальных 1.2, скорее 1.3 — но это если «без напряга», то все же от 1.5, да. С глазом, кстати, та же фигня ;).

Что за цифры и откуда взялись именно такими?

Из опыта исключительно. Снимаем миру штриховую и смотрим. Снимаем текстовую миру и смотрим. Как вы и упоминали, различимость текста отличается от различимости штриховой миры.

С этим не спорю. Только фотомодуль фотомодулю рознь. Условно APS-C на 6 мпикс (Никон Д70) и смартфон на 16 мпикс. Думаю даже «2 раза» для последнего будет недостижимой мечтой)) Поэтому и удивился каким-то обобщенным данным.

Так и разброс 1.5-2 (а тем более 1.25-2) по меркам фото очень ощутимый же. В него уложится :). Кстати, в оценке миры ещё много субъективизма все равно. Ну вот штриховая мира, линии уже не сливаются (это в районе пикселя на линию, линии нечеткие, но периодическая структура с изменением яркости объекта видна, кстати, даже она видна даже при менее пиксел/линию, но апериодически) — считать ли это пределом разрешающей способности!? Или подняться выше, чтобы края были четкие, но тогда мы получим те самые полтора пикселя на линию? Вот как то так. В буквах ещё хуже, где «угадывание формы» превращается в чётко различимую букву?

С субъективизмом все просто) Каждый вырабатывает свои критерии когда линии уже четкие. Тест ведь скорее сравнительный, чем абсолютный.

А 1.5-2 мало для передачи всей палитры ощущений. Ну не передает 16 мп смарт настолько мелких деталей как 6 мп камера. Где-то на четверть-треть хуже, что уже дает х4

Тут очень вариативно, от качества матрицы, обработки и количества света. Если 16 не дутые, то при хорошем свете и неагрессивной обработке — передаёт. Но напрямую ждать качества «пиксел в пиксел» от такой мелкой матрицы — бессмысленно. Строго говоря, и на 6 кропа это уже проявляется. Последняя матрица, где я видел, чтобы каждый пиксел нёс четкое инфо — это было где-то во времена 2Mpix сенсоров Sony.

В том и дело что дутые. Осталось определить насколько.

И кажется нашел объяснение нашему разногласию. На мире мы оцениваем деградацию в каждом измерении по отдельности. Оно как раз в 1.2-2 раза. Ну может чуть больше)). Что означает квадратичное уменьшение площади (мегапикселей), вплоть до х4, и сходится с моими наблюдениями. То есть разногласий то и нет))

Да, я говорил в рамках расчетов «вдоль одного измерения».

Это потому что на сенсоре пиксели представляют собой байеровскую матрицу — половина зелёных, и по четверти красных и синих. И для восстановления полноцветной картинки используется алгоритм демозаика

Так же не забывайте про теорему Котельникова — для восстановления данных определённой частоты частота сэмплирования должна быть в 2 раза больше

Ваши аргументы действительны для лбого фото. Методика показывает себя скорее в сравнении. Привести к общему знаменателю, самому увидеть бессмысленность гонки мегапикселей, разную информационную насыщенность пикселей разных фотомодулей, когда 48 оказывается хуже 7 мпкс.

Ваши аргументы действительны для лбого фото. Методика показывает себя скорее в сравнении. Привести к общему знаменателю, самому увидеть бессмысленность гонки мегапикселей, разную информационную насыщенность пикселей разных фотомодулей, когда 48 оказывается хуже 7 мпкс.

Ну хрень же полная. Крошечной матрице телефона дай бог выдать разрешение для соцсетей (~1Мп), чтобы нормально смотрелось (тем более при неоптимальном свете). Чтобы разрешить 50Мп, нужна ФФ- или СФ-матрица и огромный объектив стоимостью в иномарку.

Победа маркетологов над разумом. Скорей бы уже взяли какой-нибудь другой показатель для маркетинга (например, динамический диапазон) и начали пиарить его.

Хрень-не хрень, а с расстояния метров в 150 номера на машине на фото, снятом с galaxy s9/s10,не различимы полностью, а на фото,снятом с какого-то xiaomi из бюджеток ( mi9t вроде? не уверен) ,с 48мпикселей — чётко читаемы.

Мне такая «победа маркетологов» нравится, даже если они сами сидят в телефоне,и рисуют эти номера.

В теории увеличение пикселей перестало давать прирост качества где-то на 8мп. Но на практике чем больше тем лучше качество. Если теория расходится с практикой значит что-то не то именно с теорией, а не наоборот.

В теории для большего числа пикселей нужна большая матрица, чтобы на каждый пиксель приходилось достаточное количество света. А не 100500 Мп в глазке пуделя на телефоне. И на практике то же самое, затушеванное computational photography и прочими измышлизмами.

В теории увеличение пикселей перестало давать прирост качества где-то на 8мп. Но на практике чем больше тем лучше качество. Если теория расходится с практикой значит что-то не то именно с теорией, а не наоборот.

Лучше бы они физически размер пикселя увеличили вместо этих бредовых склеек. Глядишь бы уже и в самом деле смартфоны научились бы хорошо фоткать в любых условиях, тем более, что размеры матриц уже стали неплохими.

Дико извиняюсь, но для увеличения размера пикселей необходимо увеличивать фокусное расстояние или уменьшать действующее отверстие, а так да)

Для увеличения размера пикселей нужно увеличивать размер матрицы

Для «бредовых склеек», как выразился человек выше, тоже нужно увеличивать размер матрицы, так как наука пока не позволяет уменьшать пиксели до бесконечности (а точнее <0.7 мкм). Поэтому можно либо делать "склейки", либо увеличивать размеры пикселей.

Не буду строить из себя профессионала, ибо не являюсь таковым, но в чём принципиальная разница между склейкой четырёх пикселей и физическим увеличением самого пикселя? С точки зрения микроэлектроники, в которой я неплохо сведущ, это требует только изменения в маске для литографии. А вот каким образом это сразу начнёт влиять на фокусное расстояние и действующее отверстие — сие для меня загадка. Если вам не трудно, просветите, пожалуйста.

Я тоже не строю, это базовые знания фотографии) Если коротко, то вопрос в разрешающей способности объектива и дифракции на круглом отверстии. А если долго, то отраженный от точки обекта свет после фокусировки объективом и дифракции представляет собой кружок с неравномерной освещенностью, большая часть в центре, меньшая по краям. Чтобы два кружка от соседних точек не смешивались, нужно чтобы пики освещенности находились на определенном расстоянии, а зоны меньшей освещенности пересекались. Эти условия зависят от длины волны, фокусного рассотяния и действующего отверстия. Именно под эти условия и расчитаны все оптические системы смартфонов и нельзя увеличить размер пикселя, не изменив все остальное. Хотя нет — вру) Если кружок придется на несколько пикселей, то они худо-бедно все получат информацию. А если наоборот, после увеличения размера пикселя на него придется неколько кружков от разных точек, то информация потеряется. Как-то так.

Спасибо за объяснение!

познавательно. спасибо!

Простите, но даже без каких-либо знаний фотографии и микроэлектроники, это объяснение просто противоречит здравому смыслу. Вы хотите сказать, что для производителя дороже/тяжелее сделать объектив с низкой разрешающей способностью, нежели с высокой? Когда речь идет о матрицах вроде квад байер, объектив должен «разрешить» сверхвысокое разрешение матрицы (простите за тавтологию). Куда проще объединить 4 пикселя в один физический большой, чем делать линзу с высокой разрешающей способностью, чтобы тот самый кружок рассеивания не выходил за пределы микроскопического пикселя.

Владимир, приветствую! При всем уважении, ну нельзя же так оперировать словами и закреплять в массовом сознании свои/общераспространенные заблуждения):

увеличение размера матрицы не может в принципе увеличить количество попадающего на нее света, за это отвечает объектив (действующее отверстие, фокусное расстояние, качество стекла).

объединение нескольких пикселев в один также должно быть «умным». Например одна деталь объекта съемки «отобразилась» на несколько пикселей, и, если цвет один, то возможно объединение. А если деталь объекта «уместилась» всего на одном пикселе, а рядом детали другого цвета, то только алгоритм решает, «съесть» эту информацию, объединив с соседними, или оставить.

Ну и инновационность Samsung даже не обсуждается, после исследований Juha Alakarhu и Со для Nokia в 2012.

У меня MR всякий раз когда я хочу почитать что-либо про «Эппл всё» или, там, новости операторов. Значит ли это, что один сайт равносилен таблеткам?

А что мешало Самсунгу сразу сделать 12Мп-матрицу с 2.4 пикселями? Зачем это деление и склейка?

Тогда ему пришлось бы поставить объектив от зеркалки 🙂